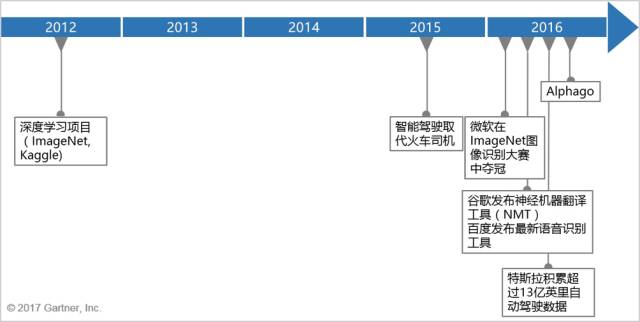

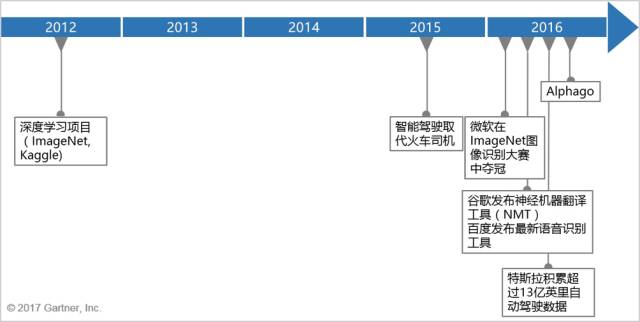

人工智能(AI)在过去的五年中取得了长足的进步(见图一)。从虚拟客户助理到物联网,企业已经在大量应用中使用人工智能。然而,大多数企业仍然处于测试和学习阶段。他们还没有大规模地利用人工智能来实现差异化的应用程序。不过,商业和IT领导者很快就会开始向首席信息官(CIO)展示更多雄心勃勃的人工智能项目计划。

图一:近五年人工智能重大进展

Gartner最近的一项调查发现,在35%到40%的案例中,CIO在人工智能项目的发起、筹资和决策环节上起到至关重要的作用。CIO决定企业的能力是否已经足够成熟,从而能够驾驭人工智能并取得成功。

如果企业缺乏这些能力,人工智能项目将浪费资源,并可能伤害企业品牌形象。CIO应从以下四个方面进行评估,以确保提出的人工智能商业计划能改善业务并创造价值:商业目标、数据、监管、工具。

如何做出成功的商业计划

人工智能商业项目可能会由于企业没有明确想要实现的目标和缺乏项目执行能力而失败。人工智能项目失败并不是因为技术不奏效,而是因为业务范围、设计、和业务目标在三个方面不足造成的。

1.商业目标

不现实或不清晰的业务目标会导致麻烦。CIO应确保任何计划的人工智能项目有明确对应的业务场景。例如,美国银行上线的客户问答机器人Erica,可以回答客户对他们帐户的问题。Erica在一个特定的领域解决特定的问题。这样一来就缩小了设计人员需要设计的场景。应用领域越窄,企业希望通过人工智能实现目标的可能性就越大。像Erica这样的项目通过缩小覆盖范围来提高客户满意度。

2.人工智能项目的资源

根据Gartner的调查显示,54%的企业认为缺乏技能是人工智能项目通向成功最大的阻碍和挑战。此外,人工智能项目还可能产生巨大的费用,还需要一个相当长的时间来发展成规模。

与可以控制其输入和输出的常规软件不同,人工智能应用程序更加开放,接受可变的输入和响应方式。

这种不可预测性使得研发人员要更广泛地检查各种可能性。此外,人工智能程序需要时间对大数据集进行训练,甚至可能需要通过与专家互动来训练。与此同时,人工智能应用程序可能需要大量的硬件和基础设施。

CIO应该确保人工智能项目运作过程中能够获得足够技术和非技术资源。例如,大多数Gartner的客户没有数据科学家员工和人工智能开发人员,很少企业高管有人工智能专业知识。

3.执行商业计划的方式

企业执行商业计划的方式也可能会造成一系列问题。大多数情况下,人工智能应用程序是由一个单独的小型创新团队开发而成。因此,他们可能和外部现实世界脱节,且团队还可能仅通过在三到四个数据仓促完成应用程序的开发。那么结果很可能是程序的性能令人失望。更糟的是,在应用程序中的分析模型和算法是很难被纠正的。

最后,这种流程还被认为是标准的人工智能项目开发流程。也就是说,企业领导或明或暗地将这一商业项目的责任委托给IT部门。这是危险的,因为人工智能直接影响到业务流程、人力资源和战略决策。CIO应该确保这个商业项目由多方业务领导共同承担责任、共同合作,并在这个项目上投入充足的时间和精力。

良好的数据管理与分析

人工智能应用程序只有和数据一起训练才能运作起来。数据质量和持续训练至关重要。如果数据不充分、不准确、不一致、不完整或者有偏,那么人工智能项目将会失败。企业不能保证给人工智能项目多少数据才算足够,除非他们有成熟的数据管理和分析程序系统。CIO一开始就应该对其组织的能力进行诚实的评估。

然而,即使有良好的数据管理,数据仍会让人工智能项目出现问题:

1、数据量:人工智能应用程序可能为了达到预期效果,从而需要太多的数据来建立精确的分析模型。例如,图像识别应用程序可能需要1000张照片对每个类的对象进行训练。

2、数据质量:常规的数据处理方法可能不适用人工智能项目。未正确标识的数据集也会导致项目失败。而太整齐的数据集则可能导致模型缺乏鲁棒性。一个完美的数据集也可能由于底层的分析模型缺乏考虑现实情况而导致项目失败。

3、数据可用性:许多人工智能项目需要企业本身不具备的数据。企业必须从第三方或潜在客户那里获取,但由于各种原因未必能拿到。用于可穿戴设备的人工智能应用程序需要患者提供健康信息,但是受到法律限制无法分享使用,尤其是涉及多个司法管辖区。商业数据提供商开价太高也是一个阻碍因素。

4、数据波动性:在某些情况下,数据可能变得太快以至于人工智能程序上无法使用。数据波动性过大可能会压垮计算机设备,需要采用特殊的硬件设备。

扩展治理框架缓解风险

人工智能应用程序越复杂,它对人类的影响就越大。常规应用项目开发的监督对于人工智能是不充分的,特别是如果它是面向外部的。如果人工智能应用程序出现故障,用户可能会遭受名誉、财务上的损失甚至人身伤害。此外,人工智能应用造成的不可预见的结果会由于多变的商业环境和监管不足成为更大的风险。

缺乏监督可能源于:

1、监督程序建立的方式;

2、不适当的或不足的管理结构;

3、对于分析模型过于自信;

4、过于依赖IT技术而缺乏主观判断。

企业应该审查人工智能应用的伦理问题(也许是设立一个独立的审查委员会)。伦理问题常常来自于不会被怀疑的假设或应用程序的非预期扩展。许多人工智能应用程序给出了有偏的结果,是因为它们是在项目领导者没有意识到的情况下对有偏的数据集进行训练。一些可以识别语音的智能设备时时在监听着屋内的对话,如果处理不当,谈话内容可能会被利用。

法规方面,许多人工智能应用程序都会收集用户信息。许多国家和司法管辖区都有数据隐私法,人工智能项目应该遵守这些法规。此外,CIO应该确保公司拥有人工智能项目产生的大数据的所有权,特别是企业与合作伙伴一起开发或运行人工智能程序。

人工智能应用可能会造成客户体验不佳、不良宣传效果和品牌形象受损的结果。不管人工智能应用程序是脚本化还是非脚本化,项目设计者都不能预见每一个结果。所以批准每一个人工智能项目,意味着CIO接受这种风险。他们应该坚持执行项目计划内容,包括与企业操作风险和安全政策相协调的风险评估和风险缓解对策。

人们应该对机器反馈的结果不断地观察和测试。CIO将其治理框架扩大到人工智能项目,以确保其不会无意中造成损害。

治理框架应确保:

1、透明度:人工智能应用程序的输入和输出应该是可以解释的,这是满足监管要求的先决条件。

2、信任:结果都是概率性的,没有100%肯定的。但太高的不确定性可能会影响采用。

3、多样性:为了确保良好的结果,人工智能应用需要思想、问题、数据、算法和工具全方面的多样性。

对人工智能工具和技术不要过于理想化

人工智能技术仍处于发展的早期阶段。他们中的大多数需要至少5年才能达到成熟。因此,想要开发人工智能应用程序的企业只能使用有限的工具。CIO应该注意工具本身的缺陷,它们协同工作的方式以及它们配套的基础设施:

1、人工智能工具都是为专项开发的,充分利用好业务专家建议使用的特征变量是成功的关键,否则可能会引起问题。

2、大多数人工智能工具缺乏协作的功能,这个问题很影响跨部门或跨功能人工智能程序的发挥。

3、人工智能程序训练有一定难度,需要数据专家和业务专家的指导,经过很多轮培训、测试和调整,才能生产比较可靠的运算结果。

有些情况可能需要多个人工智能工具协同工作。例如,银行可能希望它的聊天机器人能同时将信息反馈到欺诈探测应用程序,根据反馈的结果再次训练聊天机器人。然而,大多数人工智能工具在开发时并没有考虑多工具协同工作,原因如下:

1、集成多种人工智能技术是很困难的;

2、分析模型往往不能跨平台管理;

3、必须调和不同工具的信息和流程结果。例如,预测分析应用程序的建议也是客户记录的一部分。

人工智能应用程序通常处理大量数据,可能需要相当大的处理能力。企业可能无法提供足够的计算资源。

CIO应该检查人工智能应用提出所需的技术需求,判断如何通过可获得的工具、集成芯片和计算资源来支持这些需求。

给正在建设或扩大数字业务的CIO的建议

1、找出至少三个独立的人工智能商业项目并在明年投资。倾向于简单和可靠的项目,避免那些顶尖技术研究上的项目。

2、从四个方面评估所有人工智能产品:商业目标、数据、监管和工具。

3、将计划的功能划分为不构成挑战的、挑战但有对应解决方案的和无法实现的三类。根据需求及时调整项目计划。

4、请首席数据官或数据分析主管提供一份关于人工智能进展的季度报告,包括技术水平、启动项目和规章制度。任命一个人工智能商业项目负责人,从竞争对手和潜在的竞争对手的资料中确定人工智能相关项目早期的评价指标。

5、与人力资源部门合作,在企业中引进和发展人工智能人才。定义你的组织正在寻找的技能。

参考资料:

1、本文是基于Gartner对人工智能、机器学习、智能机器人领域的初步研究和对人工智能项目的成功与失败的次级研究撰写而成。同时我们还听取了83位来自Gartner学术研究四月调研的IT和商业领袖的观点(参见”Where You Should Use Artificial Intelligence — and Why”)

2、P.Crosman. "Bof A Gives Its Bot Time to Become a Banker."发表于American Banker. 2017年5月16日

3、R.Dipshan. "TheActual Cost of In-House Artificial Intelligence Adoption."发表于Inside Counsel. 2017年2月17日

4、 "WhatIs the Minimum Sample Size Required to Train a Deep Learning Model — CNN?"

5、HReese. "Top10 AI Failures of 2016."发表于TechRepublic.2016年12月2日

6、E.Pariser. "BewareOnline 'Filter Bubbles.'"发表于TED. 2011年3月

文章来源:Gartner

分析师:David Furlonger,Tom Austin